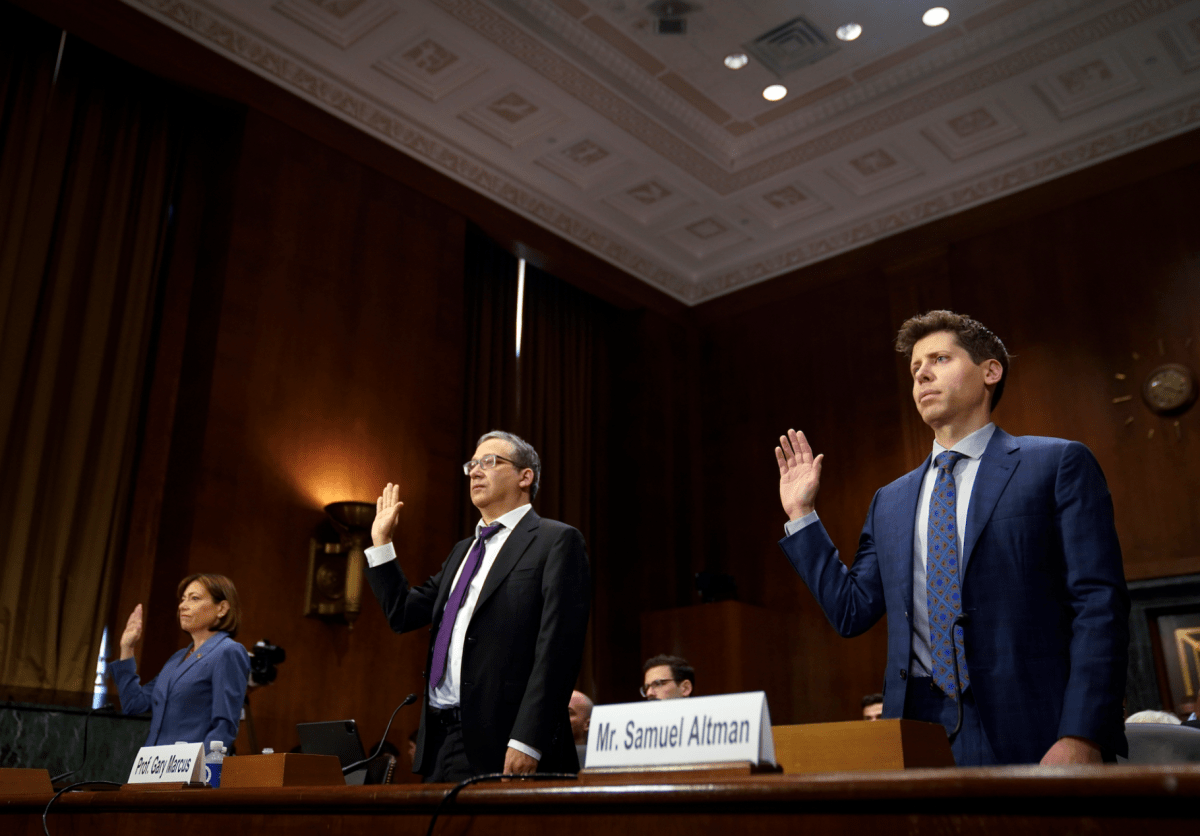

El martes de esta semana, el neurocientífico, fundador y autor Gary Marcus se sentó entre el director ejecutivo de OpenAI, Sam Altman, y Christina Montgomery, directora de privacidad de IBM, mientras los tres testificaban ante el Comité Judicial del Senado durante más de tres horas. Los senadores se han centrado en gran medida en Altman porque actualmente dirige una de las empresas más poderosas del planeta y porque Altman les ha pedido repetidamente que lo ayuden a regular su trabajo. (La mayoría de los directores ejecutivos ruegan al Congreso que deje su industria en paz).

Aunque Marcus es conocido en los círculos académicos desde hace tiempo, su estrella ha estado en racha últimamente gracias a su boletín («El camino hacia la IA en el que podemos confiar«), un pódcast («Humanos contra máquinas“), y su relativa inquietud en torno al aumento descontrolado de la IA. Además de las calificaciones de esta semana, por ejemplo, apareció este mes en Bloomberg TV y apareció en The New York Times. revista dominical Y cableado entre otros lugares.

Debido a que la audiencia de esta semana parecía verdaderamente histórica en muchos sentidos: el senador Josh Hawley calificó a la IA como «una de las innovaciones más tecnológicas en la historia de la humanidad», mientras que el senador John Kennedy quedó tan encantado con Altman que le pidió que eligiera sus propios reguladores, también quería hablar con Marcus para discutir la experiencia y ver qué sabe sobre lo que sucede a continuación.

¿Sigues en Washington?

Todavía estoy en Washington. Me reúno con legisladores y su personal y varias otras personas interesantes y trato de ver si podemos hacer realidad el tipo de cosas de las que he estado hablando.

Usted enseñó en la Universidad de Nueva York. Ha cofundado varias empresas de IA, entre ellas A con el famoso roboticista Rodney Brooks. Entrevisté a Brooks en el escenario en 2017 y dijo que no creía que Elon Musk realmente entendiera la IA y que pensaba que Musk estaba equivocado al decir que la IA era una amenaza existencial.

Creo que Rod y yo compartimos el escepticismo sobre si la IA actual se parece en algo a la inteligencia artificial general. Hay varios problemas que debe resolver. Una es: ¿qué tan cerca estamos de AGI y la otra es qué tan peligrosa es la IA actual que tenemos? No creo que la IA actual que tenemos sea una amenaza existencial, pero es peligrosa. En muchos sentidos, creo que es una amenaza para la democracia. No es una amenaza para la humanidad. No va a acabar con todos los humanos. Pero es un riesgo bastante serio.

No hace mucho estabas debatiendo Yann LeCun, científico jefe de IA en Meta. No se lo que este obturador estaba en el punto: ¿el significado real de las redes neuronales de aprendizaje profundo?

Así que LeCun y yo discutimos muchas cosas durante muchos años. Tuvimos un debate público que David Chalmers, el filósofo, moderó en 2017. Traté de conseguir [LeCun] tener otro debate real desde entonces y no lo hará. Prefiere subtwittearme en Twitter y cosas así, que no creo que sea la forma más adulta de tener conversaciones, pero como es una figura importante, respondo.

Una cosa en la que creo que no estamos de acuerdo [currently] es, LeCun piensa que es bueno usar estos [large language models] y que no hay daño posible aquí. Creo que está muy equivocado al respecto. Existen amenazas potenciales para la democracia, que van desde la desinformación deliberada producida por malos actores hasta la desinformación accidental, como el profesor de derecho que fue acusado de acoso sexual cuando no lo cometió. [to the ability to] dando forma sutil a las creencias políticas de las personas en base a datos de entrenamiento de los que el público ni siquiera sabe nada. Es como las redes sociales, solo que más insidiosas. También puedes usar estas herramientas para manipular a otras personas y probablemente engañarlas para que hagan lo que quieras. Puedes escalarlos masivamente. Definitivamente hay riesgos aquí.

Dijiste algo interesante sobre Sam Altman el martes, diciéndoles a los senadores que no les dijo cuál era su peor temor, que llamaste «pertinente», y redirigirlos hacia él. Lo que todavía no ha dicho es nada sobre las armas autónomas, que hablé con él hace unos años como una preocupación importante. Pensé que era interesante que las armas no aparecieran.

Hemos cubierto mucho terreno, pero hay mucho que no hemos cubierto, incluida la aplicación de la ley, que es realmente importante, y la seguridad nacional y las armas autónomas y cosas por el estilo. Habrá varios más [these].

¿Hablamos de sistemas de código abierto versus sistemas cerrados?

Apenas llegó. Esta es obviamente una pregunta muy complicada e interesante. La respuesta correcta es realmente poco clara. Quieres que la gente haga ciencia independiente. Tal vez desee tener algún tipo de licencia para las cosas que se implementarán a gran escala, pero conllevan riesgos particulares, incluidos los riesgos de seguridad. No está claro que queramos que todos los actores maliciosos tengan acceso a herramientas arbitrariamente poderosas. Así que hay argumentos a favor y en contra, y la respuesta correcta probablemente sea permitir un grado razonable de código abierto, pero también limitar lo que se puede hacer y cómo se puede implementar.

Cualquier pensamiento específico sobre la estrategia de Meta de dejar su modelo de lenguaje en el mundo para que la gente juegue?

no creo que sea genial [Meta’s AI technology] LLaMA está aquí para ser honesto. Creo que fue un poco descuidado. Y, ya sabes, es literalmente uno de los genios que sale de la botella. No había una infraestructura legal en el lugar; no consultaron a nadie sobre lo que estaban haciendo, que yo sepa. Tal vez lo hicieron, pero el proceso de decisión con esto o, digamos, Bing, es básicamente justo: una empresa decide que vamos a hacer esto.

Pero algunas de las decisiones que toman las empresas podrían ser perjudiciales, ya sea en el futuro cercano o en el largo plazo. Así que creo que los gobiernos y los científicos deberían desempeñar cada vez más un papel en decidir qué sucede [through a kind of] FDA para IA donde, si desea realizar una implementación a gran escala, primero debe intentarlo. Hablas de costo-beneficio. Le das otra oportunidad. Y, en última instancia, si estamos convencidos de que los beneficios superan los riesgos, [you do the] distribución a gran escala. Pero en este momento, cualquier empresa, en cualquier momento, puede decidir lanzar algo a 100 millones de clientes y hacerlo sin ningún tipo de supervisión científica o gubernamental. Debe tener un sistema en el que ciertas autoridades imparciales puedan intervenir.

¿De dónde vendrían estas autoridades imparciales? ¿No todos los que saben cómo funcionan estas cosas ya trabajan para una empresa?

No soy. [Canadian computer scientist] Yoshua Bengio no lo es. Hay muchos científicos que no trabajan para estas empresas. Es una preocupación real, cómo obtienes suficientes de estas fichas y cómo logras que lo hagan. Pero hay 100.000 personas de TI con alguna faceta de experiencia aquí. No todos trabajan para Google o Microsoft bajo contrato.

¿Le gustaría desempeñar un papel en esta agencia de IA?

Estoy interesado, creo que cualquier cosa que construyamos debe ser global y neutral, probablemente sin fines de lucro, y creo que tengo una buena voz neutral aquí que me gustaría compartir y tratar de llevarnos a un buen lugar.

¿Cómo es sentarse frente al Comité Judicial del Senado? ¿Y crees que te volverán a invitar?

No me sorprendería si me invitaran de nuevo, pero no tengo ni idea. Me conmovió profundamente y me conmovió mucho estar en esta sala. Es un poco más pequeño que en la televisión, supongo. Pero se sentía como si todos estuvieran allí tratando de hacer lo mejor por los Estados Unidos, por la humanidad. Todos sabían el peso del momento y obviamente los Senators trajeron su mejor juego. Sabíamos que estábamos allí por una razón e hicimos lo mejor que pudimos.